边缘运算,一股方兴未艾的风潮

近几年行动通讯、人工智能、物联网及相关是热门应用,而且未来也展现出「万物皆智能(AIoT = AI + IoT)」的趋势。

不论是家电、交通、零售、虚拟扩增实境(AR/VR/XR)、人机互动、医疗、食安、农业、金融、安全监控、电商平台及城市环境等等,无一没有智能管理、分析及预测。这其中「边缘运算」(Edge Computing)(也称「边缘计算」)是一股即将兴起的风潮。

「边缘运算」即将兴起

云端及边缘运算

2012年「深度学习(类神经网络)」技术的突破带动了新一波「人工智能」崛起,其中最大功臣莫过于绘图芯片(GPU)。接踵而来的是大量的建置以GPU为主的深度学习计算用服务器来进行高速运算,不论是影像(对象)辨识、人脸(性别、年纪、情绪)识别、自然语言分析、语言翻译、文义提取、文艺创作等等都要靠强大的云端(无论公有云或私有云)计算才能完成。

虽然云端可获得接近无限的计算能力,但有太多场合基于个人隐私(资料保密)问题不能上网,或者是计算延迟性太高不符实务需求,更重要的是一直上网利用云端服务(计算、储存)要一直付钱,这可是使用者最不乐见的,因而在此需求下「边缘运算」应运而生。

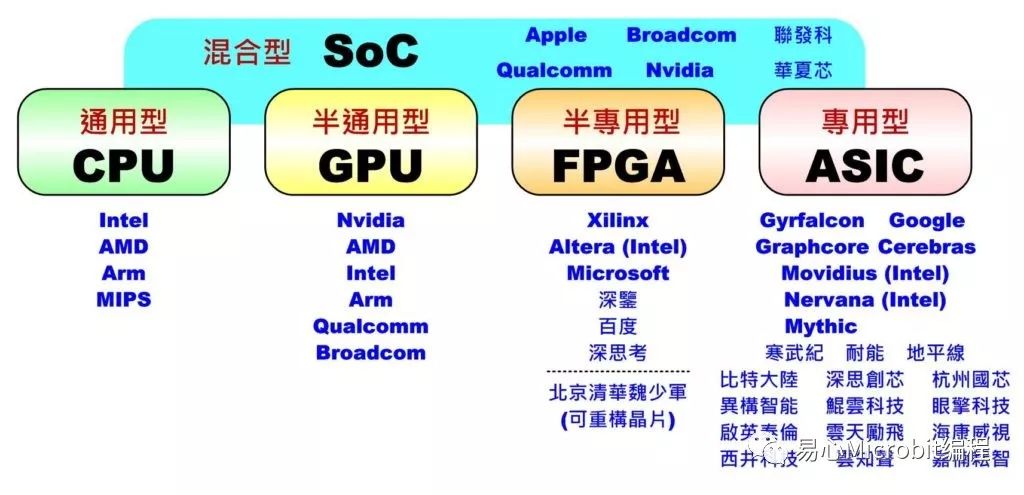

边缘计算强调可针对特定需求只作单一或少量功能,因此不需像训练时所需的巨量运算,只需利用训练好的模型在特定排程或时间内完成推论(Inference)即可,运算量相对减少很多,所以大多数情况下可利用AI芯片(或神经网络加速)(CPU, GPU, FPGA, ASIC, SoC等)即可达成。(有兴趣的朋友可参考之前的文章「人工智能AI芯片与Maker创意接轨(上)(中)(下)」)。

AI芯片类型

到底要多边缘才叫边缘运算?

目前业界所谓的边缘运算并没有一个标准定义。

各家公司自定义的边缘运算也有极大的算力差异。有的把GPU服务器不上公有云就算是边缘运算(私有云的概念),有的把单板计算机(小型工业计算机、NAS等)加上GPU卡算成边缘运算(个人计算机概念)。而绘图芯片(GPU)最知名供货商NVIDIA也把旗下的TX2及Xavier这类SoC(内含多核CPU+GPU)所组成小型(超)高阶单板计算机也称为边缘运算。

当然也有一般我们较常听到用于嵌入式系统(如树莓派、Arm等级的开发板)配合AI芯片(如Intel Movidius等)的边缘运算。甚至应用于物联网(IoT)非实时性小型传感器网络的智能边缘运算的普通单芯片MCU(如Cortex-M系列)也可都算是边缘运算。

综合以上所述,只要AI推论计算部份不上网都可以算是边缘运算。但个人比较倾向功率小于10瓦(或许小到1W)、算力小于1TFlops(或许小到10GFlop)、可利用行动电源(5V/2A)供电并可放到口袋中(100x100mm)的装置才算是边缘运算装置。

或许有人会问这么低的算力能作什么应用,举例来说,要花一小时走路才能到的地方,开法拉利或许很帅气,但若不赶时间时,骑个共享单车不用花什么钱、也不会花太久就可以到,还可顺便运动一下。

但若要到50公里远的地方,那脚踏车可能就不怎么方便了,此时可能要考虑机车或轿车才较能符合需求。同样地当人工智能应用场景明确时,计算量、反应时间、硬件成本就可以较容易估算出来,此时如何选择适当的边缘运算平台就显而易见了。

未来「边缘运算」虽可解决网络巨量通讯、储存空间、信息隐私、推论延迟及持续付费等问题,但需有更多解决方案来强化硬件算力(AI芯片加速)及算法优化(模型减量)。另外整体开发环境(AI框架、工具包)、设备体积、执行功耗及销售价格也是影响这项技术是否能普及的重要因素。

相信不久的将来大家就会更加了解如何依自身的场景需求找到云端及本地端(边缘)计算的合理配比,而不是全部都在云端或边缘端,如此就能让更多AI应用落地。

最新活动更多

-

6月13日立即参评 >> 【评选启动】维科杯·OFweek 2025(第十届)人工智能行业年度评选

-

即日-2025.8.1立即下载>> 《2024智能制造产业高端化、智能化、绿色化发展蓝皮书》

-

精彩回顾立即查看>> OFweek 2025(第十四届)中国机器人产业大会

-

精彩回顾立即查看>> 【线下会议】OFweek 2024(第九届)物联网产业大会

-

精彩回顾立即查看>> 2024先进激光技术博览展

-

精彩回顾立即查看>> 全数会2024中国深圳智能制造与机器人展览会

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论