Wave Computing推出从云端到边缘的计算平台-TritonAI 64 IP平台

2019年7月1日,Wave Computing(以下简称Wave),是一家位于美国硅谷、致力于推动人工智能深度学习从边缘计算到数据中心的计算加速方案的公司,近日于深圳参加了由电子发烧友网举办的2019人工智能技术峰会。本次大会,以“加速中国 AI 落地” 为主题,旨在为人工智能产业上下游搭建一个技术交流、资源对接和产品落地的平台。Wave Computing中国区总经理熊大鹏博士应邀出席本次大会,与人工智能芯片、算法、系统和平台供应商与系统集成商等厂商分享了Wave服务于AI边缘计算的芯片设计——TritonAI™ 64 IP平台。

Wave Computing成立于2010年,其核心产品数据流处理器单元(DPU)采用非冯诺依曼(von Neumann)架构的软件可动态重构处理器CGRA(Coarse grain reconfigurable array/accelerator)技术,适用于大规模异步并行计算问题。其主要优势是使得硬件更加灵活地适配于软件,在可编程性(或通用性)和性能方面达到很好的综合平衡,降低AI芯片开发门槛,不会受到GPU等加速器中存在的内存瓶颈的影响。独创的“软件可动态重构处理器架构(CGRA)以及数据流(Data Flow)计算”正成为AI计算领域具有革命性意义的处理器架构。它旨在通过基于数据流架构的一系列产品改变传统的人工智能计算。

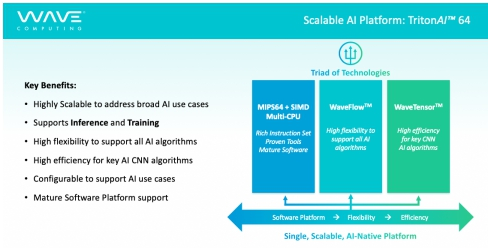

2019 年,Wave Computing针对边缘计算市场的算力需求,将MIPS技术与Wave旗下WaveFlow™和WaveTensor?技术相结合,推出TritonAI™ 64 IP平台,该平台融合了Wave Computing旗下的几大核心技术,MIPS 高性能、多线程、低功耗 IP、WaveFlow™、WaveTensor™等先进技术,具有高可扩展性、高兼容性、可客制化的特点,为产品提供高效、低耗的AI计算加速能力。

作为一款高度灵活的软件平台,TritonAI™ 64 IP平台灵活适配到AI加速引擎WaveFlowTM 和WaveTensorTM,满足不断变化的AI计算需求。这些加速引擎被一个异构编程平台管理,该编程平台由一个统一的API平台管理,即Wave Run-Time (WaveRTTM)平台。WaveRT平台在 MIPS 上运行, 并帮助对 WaveFlow 和 WaveTensor 运行引擎进行编程, 以分析和执行恰当的 AI任务;这种软件集中管理的方式,可以很好地把AI应用、AI框架和 AI算法从它们依赖执行的目标计算单元抽象出来,从而可以把算法按并行执行的方式匹配到Wave相应的计算单元上去,从而提升SoC 的AI计算性能。

“TritonAI™ 64 IP平台继承了DPU对神经网络强大的原生表示和支撑能力,适配多种神经网络,对于今天各种变化不断的算法,都可以很容易地部署在TritonAI™ 64 IP平台上。这体现了Wave Computing对众多AI领域应用的深刻理解,和对客户需求的全方位考虑。”熊大鹏博士介绍道。

最新活动更多

-

6月13日立即参评 >> 【评选启动】维科杯·OFweek 2025(第十届)人工智能行业年度评选

-

即日-2025.8.1立即下载>> 《2024智能制造产业高端化、智能化、绿色化发展蓝皮书》

-

精彩回顾立即查看>> OFweek 2025(第十四届)中国机器人产业大会

-

精彩回顾立即查看>> 【线下会议】OFweek 2024(第九届)物联网产业大会

-

精彩回顾立即查看>> 2024先进激光技术博览展

-

精彩回顾立即查看>> 全数会2024中国深圳智能制造与机器人展览会

- 1 从“技术先驱”到“商业困兽”:阿里云一场未竟的突围战

- 2 "工业智能体"崛起:边缘计算与AI Agents如何重构产业未来?

- 3 大白话解释GPU的算力是怎么算出来的?

- 4 AI大模型的商业“回旋镖”,重新落到了云计算丨贸易战下的产业韧性(二)

- 5 Azure 再雄起,微软重回 AI 顶梁柱

- 6 金山云在阿里,腾讯阴影下的"突围悖论"

- 7 从“黑马”到“弃子”:京东云为何沦为云战场边缘人?

- 8 Salesforce原厂国际版进入停服倒计时,迁移还是替代迫在眉睫

- 9 华为云突破“制裁”的密码,藏在超节点里

- 10 七个月融资翻倍,投资人追着送钱,Netflix、Meta背后的独角兽凭啥叫板甲骨文|发现独角兽

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论